빅

빅웨이브에이아이

January 24, 20241회

RLHF - 어떻게 LLM의 성능을 향상시킬 수 있을까?

간단 소개

RLHF는 LLM의 성능을 향상시키기 위해 사람의 피드백을 활용하는 강화 학습 방법이며, DPO 등의 대안도 존재한다.

AI Summary

- LLM 성능 향상 방법: RLHF

- **RLHF(Reinforcement Learning from Human Feedback)**는 LLM을 사람의 의도에 맞게 통제하고 성능을 고도화하는 방법이다.

- SFT(Supervised Fine-tuning)와 RLHF를 통해 LLM의 성능을 개선한다.

- RLHF의 작동 방식 및 구성 요소

- SFT 모델에 사람의 피드백을 보상으로 제공하여 강화 학습을 수행, 사람의 선호도를 학습한다.

- Reward Model은 모델이 생성한 문장에 대한 자동 평가 모델로, 사람이 직접 리워드를 평가할 수 없는 경우에 사용된다.

- KL Divergence는 리워드 해킹(Reward Hacking) 또는 Mode Collapse를 방지하기 위한 규제항이다.

- RLHF의 대안 및 한계

- DPO(Direct Preference Optimization)는 RLHF의 복잡성과 불안정성을 보완하는 방법으로, 더 적은 모델과 자원을 사용한다.

- Rejection Sampling Fine-tuning은 리워드 스코어를 기반으로 답변을 선택하고 SFT 방식으로 학습하는 방법이다.

- RLHF는 학습 불안정성, 하이퍼 파라미터 민감성, Reward Model의 Robust성 부족 등의 한계를 가진다.

Next Feeds

LangChain: LLM 서비스를 어떻게 개발할 수 있을까?

LangChain 프레임워크 소개 및 LLM 서비스 개발 방법, 다양한 활용 예시와 향후 전망을 제시합니다.

LangChainLLM프레임워크OpenAIAgent

2024. 1. 24.

빅웨이브에이아이

Next.js에서 MSW(Mock Service Worker)로 네트워크 Mocking하기

Next.js 환경에서 MSW를 도입하여 네트워크 Mocking 문제를 해결하고 개발 효율성을 높인 경험과 팁을 공유합니다.

MSWNext.jsMocking프론트엔드테스트

2024. 1. 23.

올리브영

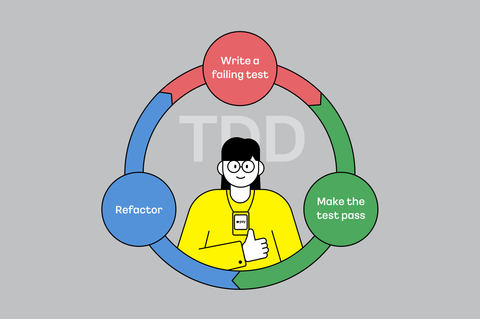

실전에서 TDD하기

카카오페이 개발자가 TDD를 실전에서 적용하며 얻은 경험과 방법론, 그리고 TDD 적용 시 고려사항을 공유합니다.

TDD테스트 주도 개발단위 테스트리팩터링일급 컬렉션

2024. 1. 23.

카카오페이

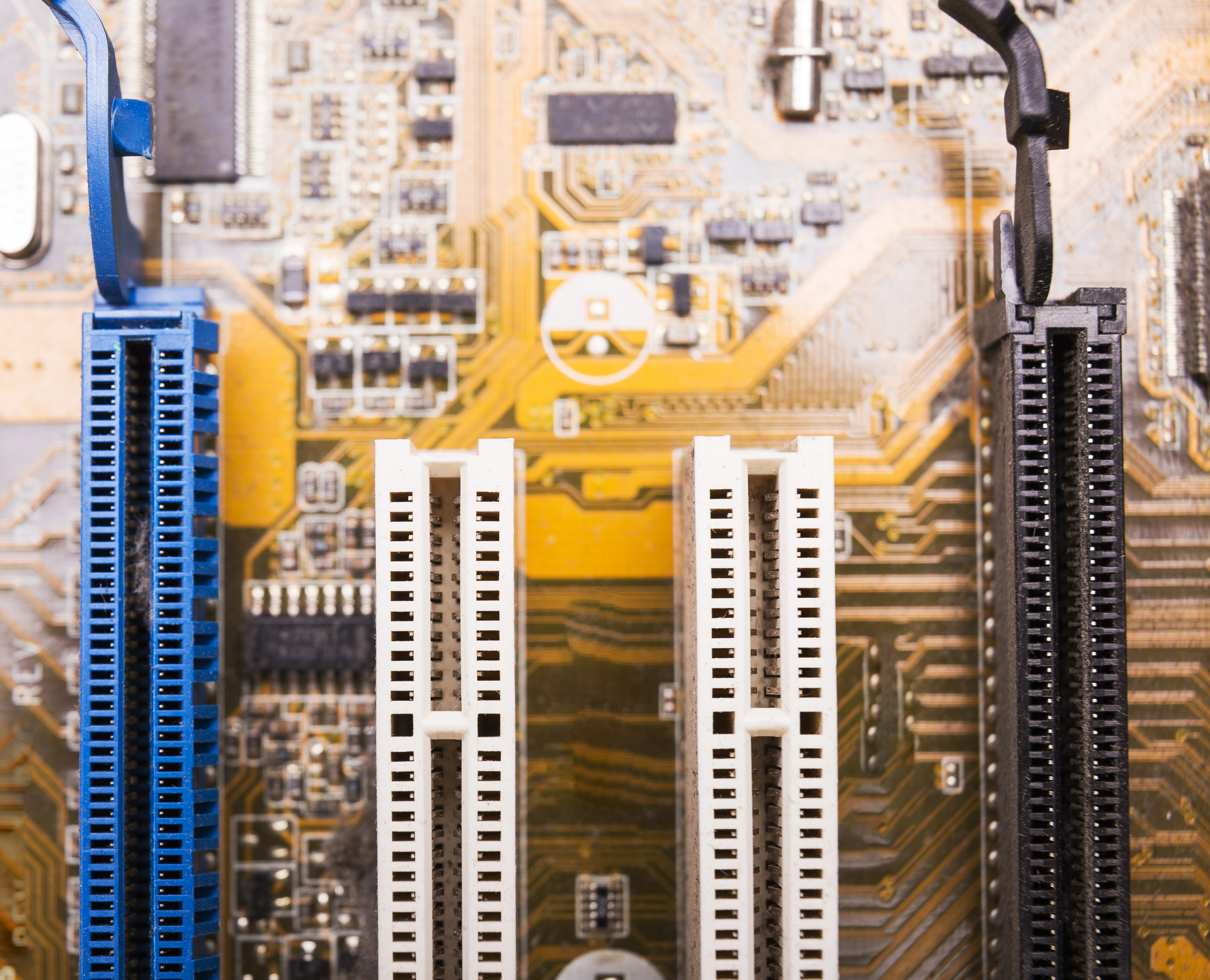

CXL 3.1 소개와 스토리지

CXL 3.1은 PCIe 6.0 지원, 캐시 일관성 강화, 메모리 공유, GFAM/GIM 도입 등 다양한 업데이트를 통해 성능과 활용성을 높였다. 스토리지와의 관계도 주목할 만하다.

CXLPCIe 6.0캐시 일관성메모리 공유GFAM

2024. 1. 22.

글루시스

고객에게 뚜렷한 경험을: 컬리의 후기 이미지 처리 기술

컬리는 라플라시안 필터 기반의 이미지 처리 기술을 통해 흐린 후기 이미지를 개선하고 고객의 구매 결정에 도움을 주고자 합니다.

후기 이미지흐림 감지라플라시안 필터이미지 처리컬리

2024. 1. 19.

컬리

Transactional Outbox 패턴으로 메시지 발행 보장하기

Transactional Outbox 패턴을 리디 서비스에 적용한 경험 공유: Polling Publisher 방식 구현, 메시지 중복 처리 방지, 성능 개선 및 모니터링 과정 설명.

Transactional OutboxEvent Driven ArchitectureKafkaPolling PublisherMessage Relay

2024. 1. 17.

리디