- LLM 튜닝은 GPU 비용 절감 및 특정 목적에 맞는 소형 모델 활용을 위해 주로 자체 호스팅 환경에서 이루어집니다. 💡

- 모델 튜닝의 주요 동기는 모델의 지식 부족(기업 내부 데이터 등)을 보완하고, SQL 생성이나 코드 작성과 같은 특정 작업에 특화시키기 위함입니다. 🎯

- 에이전틱 AI는 LLM이 외부 시스템(예: 날씨, 지리정보)과 유기적으로 연동하여 복합적인 질의에 응답하도록 하는 개념입니다. 🔗

- 알리바바의 Q1 모델은 오픈소스 중 외부 시스템 연동에 특화되어 있으며, 엔트로픽 모델은 유료 모델 중 도구 선택 능력이 뛰어납니다. 🤝

- 모델 튜닝은 수십억 개의 파라미터(신경망 행렬 원소)를 학습시키는 과정으로, 유의미한 변화를 위해 수십만에서 수백만 개의 방대한 학습 데이터가 필수적입니다. 📊

- 일반 기업 데이터는 모델 튜닝에 필요한 학습 데이터 양(보통 4만 개 수준)에 턱없이 부족하여, 7B 모델조차 효과적인 튜닝이 어렵습니다. 📉

- 모델 튜닝은 기존 모델의 지식 균형을 깨뜨려 특정 도메인에 편향되거나 일반 상식 답변 능력을 저하시킬 위험이 있습니다. ⚖️

- 모델 튜닝은 막대한 GPU 비용(추론 비용의 약 10배), 학습 데이터 구축의 어려움, 낮은 효과 등의 문제로 실제 적용이 매우 어렵습니다. 💸

- LLM 튜닝의 현실적이고 효과적인 대안은 프롬프트 튜닝으로, 추가 지침이나 지식을 프롬프트에 부여하여 모델의 동작을 손쉽게 제어하는 방법입니다. 📝

Recommanded Videos

NEW

Build a Python ML App Fast With Gradio

2026. 1. 15.

진입장벽을 확 낮춰서 누구나 구축이 가능해진 직접 만든 시스템 트레이딩 기능! 한번 써볼까요?

2025. 11. 14.

This is Unlike ANY LLM Training before 💥 World's 1st Decentralized LLM Training 💥

2024. 10. 11.

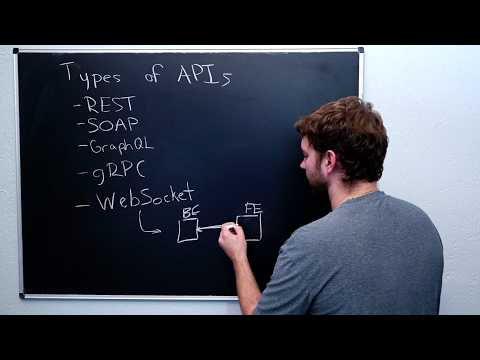

API Design and Architecture - Backend Engineering Intro (1 Hour)

2025. 8. 25.

Keeping Your Young Players Safe with KWS’ Parent Verification Service | Unreal Fest Stockholm 2025

2025. 11. 30.

미국 최대 거래소 해킹, 역시... 대응은 이렇게.! (사회공학기법)

2025. 5. 26.