- Gemma 3는 1B, 4B, 12B, 27B의 네 가지 파라미터 모델로 제공되며, 2025년 로컬 하드웨어에서 실행하기 가장 좋은 모델 중 하나로 평가됩니다. 🚀

- Ollama 리더보드에서 최상위를 차지하며, 다국어 처리 능력과 128,000 토큰의 넓은 컨텍스트 창을 자랑합니다. 🌐

- 1B 모델을 제외한 4B, 12B, 27B 모델은 이미지를 이해하는 멀티모달 기능을 지원합니다. 🖼️

- 모델 크기에 따라 필요한 메모리가 증가하며 (1B: 800MB, 4B: 3.3GB, 12B: 8.1GB, 27B: 17GB), 효율적인 실행을 위해 충분한 RAM이 필요합니다. 💾

- 논리 함정 테스트 결과:

- 부정문 다중 선택 문제에서 4B 모델이 유일하게 정답을 맞혔고, 1B, 12B, 27B 모델은 오답을 냈습니다. 🤔

- 'A'로 시작하는 단어 문장 생성 및 글자 수 세기(Lala Palooa)에서는 모든 모델이 대체로 잘 수행했지만, 글자 수 세기에서는 일부 모델이 반복에 빠지기도 했습니다. 🅰️

- 공간 추론 문제에서는 4B 모델만 정답을 맞혔고, 다른 모델들은 오답을 냈습니다. 🧭

- 유효 숫자 반올림 문제에서는 12B와 27B 모델이 정답을 맞혔고, 1B와 4B 모델은 오답을 냈습니다. 🔢

- 대수학 컨텍스트 함정 문제에서는 4B, 12B, 27B 모델이 정답을 맞혔고, 1B 모델은 오답을 냈습니다. ➕

- 시각 인식 테스트 결과:

- 1B 모델은 텍스트 전용이므로 이미지 처리가 불가능하며, 이미지 입력 시 환각 현상을 보였습니다. 👻

- 마야 상형문자 인식에서 초기에는 4B와 27B 모두 어려움을 겪었으나, 더 많은 컨텍스트(스페인어 텍스트 포함)가 제공되자 27B 모델이 정확하게 식별했습니다. 🏛️

- 'Chad GPT' 이미지에서 4B와 27B 모델 모두 그가 실제 인물이 아님을 정확히 파악했습니다. 🤖

- 강아지 이미지에서 27B 모델은 'Closed' 사인까지 인지하며 4B보다 더 미묘하고 상세한 분석을 제공했습니다. 🐶

- 전반적으로 모델 성능은 크기에 비례하지 않으며, 특정 작업에서는 작은 모델(예: 4B)이 더 큰 모델보다 뛰어난 성능을 보일 수 있습니다. ⚖️

- 멀티모달 작업에서 컨텍스트와 프롬프트 엔지니어링이 모델의 이해도를 크게 향상시킬 수 있습니다. 💡

- 로컬에서 Gemma 3 모델을 실행할 때 GPU를 100% 활용하면서도 메모리 오버로드를 피할 수 있어 효율적인 사용이 가능합니다. ⚡

Recommanded Videos

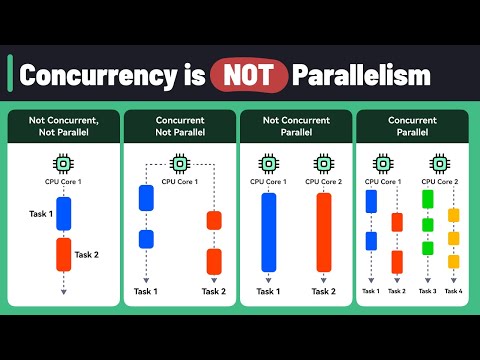

Concurrency Vs Parallelism!

2024. 7. 9.

The $150,000 NPM Disaster: How One Package Almost Crashed the Internet

2025. 8. 13.

Have you used these python functions?

2025. 10. 7.

Zed: The Open Source Agentic IDE - Use Claude Code, Codex & Gemini CLI in one place

2025. 11. 25.

![[10분 테코톡] 모코의 Java Stream API](https://i2.ytimg.com/vi/Q9aDtHS9NQg/hqdefault.jpg)

[10분 테코톡] 모코의 Java Stream API

2025. 6. 6.

How to use the .title() method in Python

2025. 12. 15.