- 최신 LLM은 계산 효율성과 의미 표현력 향상에 중점을 둡니다. 🚀

- 의미 표현력 확장을 위해 토큰 임베딩 차원을 늘리는 것이 가장 중요하며, 이는 미세한 의미와 문맥 구분을 가능하게 합니다. 🧠

- 토큰 임베딩 차원이 커질수록 더 많은 어텐션 헤드와 레이어 운영이 가능해집니다. 📈

- 계산량 감소를 위해 FFN(Feed-Forward Network)과 어텐션 계산 최적화에 집중합니다. 💡

- FFN 계산량 절감을 위해 MoE(Mixture of Experts)를 사용하며, 이는 라우터가 특정 차원에만 FFN(전문가)을 활성화하여 연산 참여 부분을 제한합니다. 🧩

- MoE는 토큰 임베딩 차원이 매우 큰 현대 LLM에서 FFN 연산을 감당할 수 있게 하는 필수 기술입니다. 🏗️

- 어텐션 계산 속도 향상을 위해 플래시 어텐션은 GPU 메모리(SRAM) 활용을 최적화하여 데이터 전송 비용을 줄입니다. ⚡

- KV 캐시 양자화는 추론 시 KV 캐시를 낮은 정밀도로 저장하여 메모리 사용량을 줄이고 재활용합니다. 💾

- GQA(Grouped Query Attention)는 여러 쿼리 헤드가 소수의 KV 헤드 그룹을 공유하며, 쿼리 값을 토큰별로 계산하지 않고 그룹별로 고정하여 KV 캐시와 쿼리 계산량을 크게 줄입니다. 🤝

Recommanded Videos

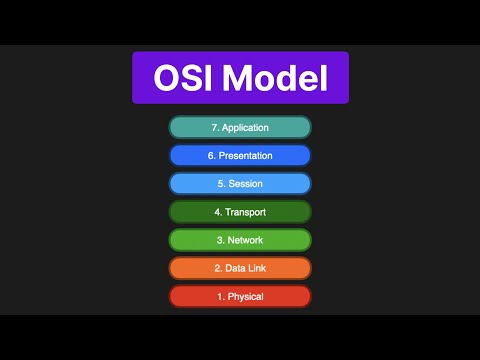

OSI Model | Simply Explained

2024. 11. 14.

Leadership interview questions for engineers: Tons of ACTIONABLE tips from ex-Google EM

2024. 5. 31.

GitHub is the Future of AI Coding (Here's Why)

2025. 11. 13.

When They Ask How Work Is Going… And I Actually Answer

2025. 3. 5.

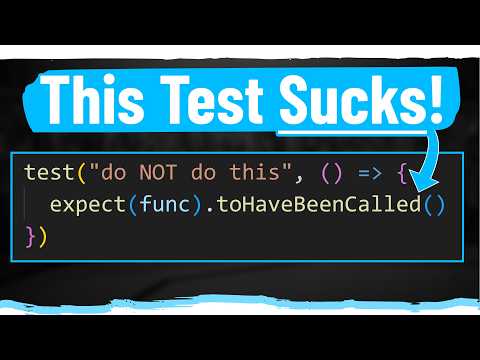

How To Write Better Tests In 6 Easy Steps

2024. 8. 13.

The OpenTelemetry Demo is the BEST way to understand Otel

2025. 2. 14.