- 트랜스포머 모델은 인코더, 디코더, 인코더-디코더 세 가지 주요 형태로 발전하며, 각 형태는 텍스트 분류, 요약, 생성 등 특정 작업에 특화되어 있습니다. 🌳

- 초기 독점 모델 중심에서 메타의 라마(LLaMA)를 기폭제로 구글 젬마(Gemma), 마이크로소프트 파이(Phi) 등 오픈소스 디코더 기반 모델의 발전이 가속화되고 있습니다. 🚀

- 트랜스포머 모델은 순환 신경망의 한계를 극복하고 자연어 처리 분야에서 전이 학습(Transfer Learning)을 효과적으로 적용할 수 있게 하여 대규모 사전 훈련 모델의 활용을 가능하게 했습니다. 🔄

- 바트(BART)는 인코더-디코더 구조의 대표적인 모델로, 인코더의 최종 출력이 모든 디코더 모듈에 주입되며, 위치 임베딩과 토큰 임베딩을 통해 일관된 벡터 표현을 학습합니다. 🏗️

- 바트 모델은 임베딩 층의 가중치를 회전시켜 마지막 출력 밀집 층으로 재사용하는 '가중치 공유(Weight Tying)' 기법을 활용하여 모델의 효율성을 높이고 파라미터 수를 줄입니다. ⚖️

- 트랜스포머 모델 내부에서는 렐루(ReLU)의 부드러운 변형인 젤루(GELU) 활성화 함수가 사용되어 모든 구간에서 미분 가능한 특성을 제공하며, 이는 모델 학습에 유리합니다. 📈

- 한국어 특화 모델인 코바트(KoBART)는 허깅페이스(Hugging Face) 트랜스포머스(transformers) 라이브러리의

pipeline함수를 통해 상품 설명 요약과 같은 다양한 NLP 작업에 쉽게 적용할 수 있습니다. 🛠️ - 텍스트를 숫자 토큰으로 변환하는 토큰화(Tokenization)는 언어 모델의 핵심 전처리 과정으로, 단순 공백 분리를 넘어 BPE, WordPiece 등 고급 기법을 통해 어휘 사전의 효율성을 극대화합니다. 🧩

Recommanded Videos

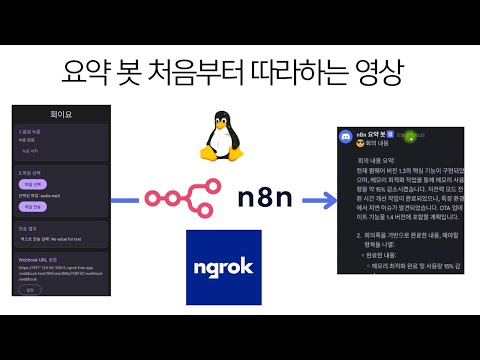

회의 요약 자동화 처음부터 따라하기

2024. 10. 3.

2024년 이노베이션아카데미 성과 공유 컨퍼런스 (INNO-CON)

2024. 12. 4.

How to use Context Managers in Python Tutorial

2025. 4. 1.

![[KO] 에이전트를 학습시킬 수 있는 리얼한 환경? | 꼬리의 꼬리를 무는 페이퍼](https://i3.ytimg.com/vi/ndrhmQUPWVE/hqdefault.jpg)

[KO] 에이전트를 학습시킬 수 있는 리얼한 환경? | 꼬리의 꼬리를 무는 페이퍼

2025. 12. 5.

Get Started with Anthropic's New 'Use Computer' API in 3 Minutes

2024. 10. 22.

Build Your Own Claude Code From Scratch

2026. 1. 9.