- AI 모델을 직접 호스팅하면 비용 절감, 데이터 프라이버시 강화, 그리고 더 큰 제어권을 확보할 수 있습니다. 💰

- Ollama는 로컬 및 VPS 환경에서 AI 모델을 쉽게 다운로드, 관리하고 REST API를 통해 앱에 통합하는 핵심 도구입니다. 🧠

- Open WebUI는 Ollama 모델 관리를 위한 사용자 친화적인 웹 인터페이스로, VPS 환경에서 모델 상호작용 및 API 연동을 간소화합니다. 🌐

- Llama 3.2 모델은 30억 파라미터의 작은 크기에도 불구하고 자동 완성 기능에서 놀랍도록 좋은 성능을 보여주어 효율성을 입증했습니다. ✨

- Next.js 앱은 커스텀 훅과 API 라우트를 활용하여 AI 기반 자동 완성 기능을 구현하며, 디바운싱 로직으로 요청 과부하를 방지합니다. 💻

- Hostinger와 같은 VPS 제공업체를 통해 AI 모델을 배포할 수 있으며, 특히 Ollama 템플릿을 활용하면 설치 과정을 크게 간소화할 수 있습니다. 🚀

- Hostinger는 Ollama 및 Open WebUI가 사전 설치된 VPS 템플릿을 제공하여 AI 모델 배포의 진입 장벽을 낮춥니다. 🛠️

- VPS 환경에서는 로컬 Ollama API 대신 Open WebUI의 API를 사용하여 외부 접근성을 확보하고, API 키를 통한 인증을 설정하는 것이 더 효율적입니다. 🔑

- 최종적으로, VPS에서 실행되는 AI 모델을 통해 Next.js 앱에서 실시간으로 정확한 자동 완성 제안을 성공적으로 구현할 수 있습니다. ✅

Recommanded Videos

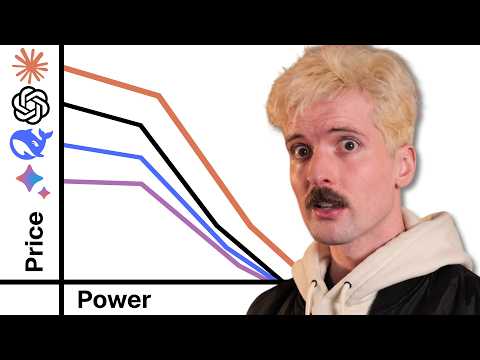

AI Models: A Race To The Bottom

2025. 3. 9.

팀에서 마니또 하다가 지갑 털렸습니다. 맥미니를 샀습니다. 뚜부인이 누워만 있습니다.

2024. 12. 15.

LegendList 2, Expo SDK 54 and React Native 1.0? - Rocket Ship 080

2025. 9. 9.

Deploying Deno with Docker

2024. 11. 14.

I Built an AI-Powered CV Screening Automation in n8n (NO-CODE) #n8n #aiagents #ai

2025. 2. 7.

The BEST Way to Stay Ahead of AI 🤖

2025. 7. 30.