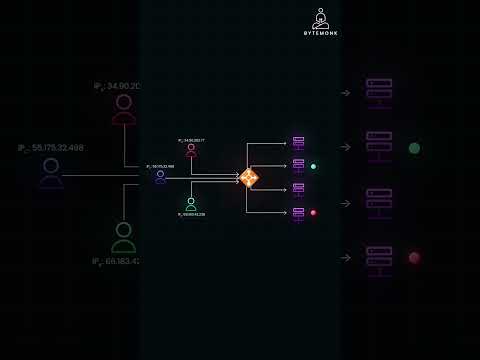

- RAG(검색 증강 생성) 시스템은 Ollama와 Qdrant를 활용하여 로컬에서 LLM을 실행하고 벡터 임베딩을 저장하는 방식으로 구축됩니다. 🛠️

- Ollama는 오픈 소스 대규모 언어 모델(LLM)을 로컬에서 실행할 수 있게 해주며, 무료이지만 ChatGPT나 Gemini 같은 대형 모델보다는 성능이 낮습니다. 💻

- Qdrant는 벡터 임베딩을 저장하는 데 사용되는 벡터 데이터베이스입니다. 🗄️

- LLM은 개인 데이터나 기업 내부 문서와 같은 특정 정보에 접근할 수 없다는 한계가 있으며, RAG는 이러한 문제를 해결하기 위한 솔루션입니다. 🔒

- LLM에 외부 데이터를 통합하는 다른 방법으로는 '커스텀 모델 구축' (매우 비싸고 시간 소모적)과 '미세 조정' (커스텀 모델보다 덜하지만 여전히 비용과 시간이 필요)이 있습니다. 💸

- KAG(캐시 증강 검색)는 모든 잠재적으로 관련 있는 콘텐츠를 LLM의 컨텍스트 창에 로드하지만, 토큰 비용, 컨텍스트 창 크기 제한, 그리고 잘못된 정보 사용 가능성이라는 단점이 있습니다. 📚

- RAG의 핵심은 사용자 질문과 관련된 '가장 관련성 높은 정보'만을 검색하여 LLM의 컨텍스트에 주입하는 것으로, KAG보다 효율적이고 비용이 적게 듭니다. 🎯

- AI가 개발자를 완전히 대체할 것이라는 우려에 대해, AI는 개발자의 효율성을 높이지만 복잡성, 레거시 기술, 환각 현상, 보안 문제 등으로 인해 인간 개발자의 역할은 여전히 중요하다고 강조합니다. 🧑💻

- LLM 사용 비용은 토큰당 과금 방식이므로, 많은 양의 데이터를 컨텍스트 창에 로드할 경우 빠르게 비싸질 수 있습니다. 💰

Recommanded Videos

The Only Accessibility Video You Will Ever Need

2024. 11. 2.

How to Use the NEW Nano Banana 2 in n8n (cheaper & no watermark)

2025. 11. 21.

AI는 경쟁자가 아닌 협력자 #AI

2024. 9. 8.

2025 04 01 개발자 상담소

2025. 4. 1.

Best Shadcn Addons You Need Right Now!

2025. 7. 6.

reverse proxies and load balancers explained

2024. 12. 30.