- AI 앱의 성공은 높은 가치, 낮은 오류 수정 노력(롤백 가능성), 그리고 오류의 낮은 영향에 달려있습니다. ↩️

- 발표자는 LangChain4j의 초기 협력자이자 Oracle의 Java 및 AI 전문가로서, 프레임워크 개선에 기여하고 있습니다. 👩💻

- 기본 RAG는 관련 없는 정보 검색, 중요한 정보 누락, 모델 혼란 등 여러 한계를 가지고 있어 프로덕션 환경에 부적합합니다. 📉

- 고급 RAG는 쿼리 변환, 다중 콘텐츠 검색, 재순위 지정 등 다양한 구성 요소를 통해 기본 RAG의 문제를 해결합니다. 🚀

- 쿼리 변환기(압축/확장)는 대화 기록을 바탕으로 검색 쿼리를 재구성하여 불필요하거나 잘못된 검색을 방지합니다. 🔍

- 쿼리 라우터와 다중 콘텐츠 검색기는 문서 외에 데이터베이스, 웹 등 다양한 소스에서 정보를 검색하고, LLM을 통해 쿼리를 최적화합니다. 🗺️

- SQL 데이터베이스 검색기는 스키마를 활용해 자연어를 SQL로 변환하지만, 보안상 프로덕션 환경에서는 엄격한 검증이 필수입니다. 💾

- 단순히 청킹하는 것을 넘어 동의어 확장, 예상 질문 기반 전처리 등 사용 사례에 맞는 스마트한 검색 전략이 중요합니다. 💡

- 재순위 지정 콘텐츠 집계기는 작은 스코어링 모델로 청크의 관련성을 평가하여 불필요한 정보를 제거하고 모델의 혼란을 줄입니다. 🧹

- 기본 콘텐츠 주입기의 프롬프트("모든 정보 사용")를 "관련이 있다면 사용"으로 변경하여 모델이 더 선별적으로 정보를 활용하도록 유도해야 합니다. ✍️

- RAG를 도구로 래핑하면 모델이 필요에 따라 RAG를 여러 번 호출하여 정보를 반복적으로 검색하고 답변을 개선할 수 있습니다. 🛠️

- 프로덕션 환경에서는 답변의 근거를 위해 원본 출처를 메타데이터에 저장하고, 사용자별 접근 권한을 하드 필터링으로 관리해야 합니다. 🔒

return immediate기능은 LLM 응답 없이 도구의 결과만 즉시 반환하여 토큰과 시간을 절약하며, 특정 작업에 대한 예측 가능한 결과를 제공합니다. ⚡- 동적 도구 추가 및 최대 순차 도구 호출 제한은 모델의 혼란을 줄이고 시스템이 무한 루프에 빠지는 것을 방지합니다. 🧩

Recommanded Videos

메타 라마4 출시! 무료 사용 사이트 및 특징 총정리!

2025. 4. 23.

🚀 Build a Full Stack AI Image Editing App with Expo, Strapi & Clerk, Neon | React Native Tutorial 🎨📱

2024. 10. 11.

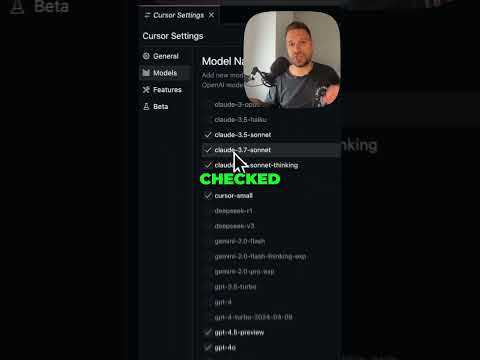

How to Make Your Cursor Code Editor 400% Smarter in 30 Seconds!

2025. 3. 1.

Ng-News 25/34: Angular 20.2

2025. 8. 26.

Next.js AI SDK Tutorial - 15 - Generate Speech

2025. 8. 20.

THIS automation framework will save DAYS of your life...

2024. 12. 26.