- 최신 VLM(Vision-Language Model)인 DeepSeek-VL2의 '그라운딩 피처'는 텍스트 쿼리를 통해 이미지 내 특정 물체의 위치를 좌표로 찾아내는 기능입니다. 📍

- 이는 기존의 고정된 클래스만 검출하던 오브젝트 디텍션(예: DETR)과 달리, 자연어 문장을 이해하여 '왼쪽에 있는 기린'이나 '강아지가 타고 있는 빨간색 자동차'와 같은 복잡한 지시로도 물체를 찾을 수 있는 '오픈 보캐블러리' 능력을 제공합니다. 🗣️

- DeepSeek-VL2는 이미지 인코더와 LLM(MOE 구조)을 결합한 트랜스포머 기반 아키텍처를 사용하며, 물체의 위치를 나타내는 토큰과 좌표(x1, y1, x2, y2)를 포함하는 특수 포맷의 시각적 그라운딩 데이터로 학습됩니다. 🧠

- 모델은 단순한 물체 찾기를 넘어, OCR처럼 캡처된 화면에서 특정 텍스트의 위치를 찾거나, 대화형 그라운딩, 심지어 여러 이미지 간의 참조(예: 첫 번째 이미지의 특정 물체를 두 번째 이미지에서 찾아줘)까지 가능합니다. 🖼️

- Grounding DINO와 같은 선행 연구가 있지만, DeepSeek-VL2는 벤치마크에서 뛰어난 성능을 보이며 파운데이션 모델로서의 잠재력을 입증했습니다. 🏆

- 주요 단점은 모델 크기가 Grounding DINO보다 10배에서 100배까지 커서 제한된 하드웨어에서의 실행 및 파인튜닝이 어렵다는 점입니다. 🐘

- 그럼에도 불구하고, 2025년 현재의 성능과 하드웨어 발전 속도를 고려할 때 2030년경에는 누구나 쉽게 사용할 수 있을 것으로 기대됩니다. 🚀

- 이러한 그라운딩 기능은 RAG(Retrieval Augmented Generation)와 결합하여 도면, 쇼핑몰 이미지, 의료 영상, 차트 등 다양한 분야의 애플리케이션에 활용될 수 있는 큰 잠재력을 가집니다. 💡

Recommanded Videos

MCP + n8n for Sales & Research: Real Business Data Enrichment Example (FREE Template)

2025. 9. 10.

![[풀버전] Local LLM](https://i4.ytimg.com/vi/KnjWSWNmmOI/hqdefault.jpg)

[풀버전] Local LLM

2025. 3. 13.

Mastering Kubernetes Ingress | Hands-on Example with Spring Boot & NGINX | @Javatechie

2024. 8. 30.

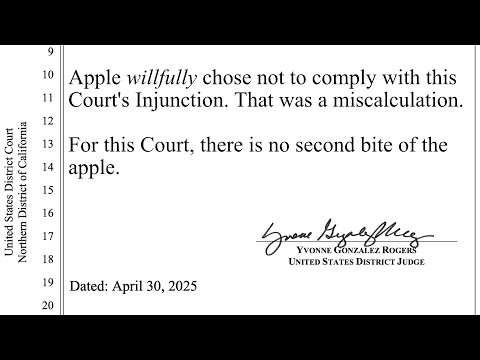

Apple has never lost this hard before

2025. 5. 1.

Kubernetes Jobs vs. Init Containers: what's the difference?

2025. 7. 27.

10 CRAZY FREE AI Coding TOOLS: THESE ARE THE AI CODING TOOLS that I USE DAILY!

2025. 4. 26.