- 대규모 언어 모델(LLM) 시장은 오픈소스(라마, 젬마, 파이, 엑사원 등)와 독점 모델(GPT, 클로드, 제미나이 등)로 다양하며, 오픈소스 공개 추세가 확대되고 있습니다. 🌐

- 메타의 라마 모델이 오픈소스 LLM의 전환점을 마련한 이후, 구글 젬마, 마이크로소프트 파이(경량 모델), 알리바바 쿠앤, 딥스크, LG AI 엑사원, 네이버 하이퍼클로바 X, 카카오 등 다양한 오픈소스 모델들이 등장했습니다. 🚀

- 허깅페이스의 오픈 LLM 리더보드는 모델 성능 비교의 복잡성 증가로 인해 중단되었으며, 사람의 평가가 개입하는 LM 아레나와 같은 리더보드가 여전히 유용하게 활용되고 있습니다. 📊

- 최신 디코더 기반 LLM(예: 엑사원)은 메모리 및 계산 효율성을 높이기 위해 멀티쿼리 어텐션(MQA)과 그룹드 쿼리 어텐션(GQA)과 같은 고급 어텐션 메커니즘을 채택합니다. 🧠

- SwiGLU(Swish-Gated Linear Unit) 활성 함수는 밀집층을 분할하고 출력을 곱하는 방식으로 작동하며, 최근 LLM에서 성능 향상을 위해 널리 사용되는 기술입니다. ✨

- RMS 정규화는 평균 계산 없이 분산만으로 정규화를 수행하는 층 정규화의 변형으로, 계산 효율성이 높고 모델 성능 저하 없이 최신 LLM에서 선호됩니다. ⚡

- 엑사원 3.5 모델은 RMS 정규화를 어텐션 및 피드포워드 모듈 앞에 적용하고, 그룹드 쿼리 어텐션과 SwiGLU를 사용하는 등 최신 LLM 설계 방식을 반영하고 있습니다. 🏗️

- LLM을 이용한 텍스트 생성 시(예: 허깅페이스 트랜스포머의 엑사원, OpenAI API의 GPT), 시스템 및 사용자 역할을 포함하는 메시지 형식을 사용하여 모델의 응답 스타일과 페르소나를 효과적으로 제어할 수 있습니다. 💬

- 보다 자연스럽고 다양한 텍스트 생성을 위해 온도(확률 완화), Top-K(상위 K개 토큰 선택), Top-P(누적 확률 P% 내 토큰 선택)와 같은 토큰 디코딩 전략이 활용됩니다. 🎲

- OpenAI GPT와 같은 독점 LLM은 API 키와 유료 구독을 통해 접근 가능하며, 강력한 텍스트 생성 능력을 제공하고 구조화된 메시지 입력을 지원합니다. 💰

- 강사는 머신러닝, 딥러닝, LLM 분야의 심화 학습을 위한 다양한 추천 도서(예: "혼자 만들면서 공부하는 딥러닝", "핸즈온 라지 랭귀지 모델")를 제시하며 지속적인 학습을 독려합니다. 📚

Recommanded Videos

연봉협상, 저는 일부러 손해 보고 들어갑니다

2025. 9. 28.

회의록 작성에서 해방시켜 줄 AI 녹음기 찐 사용기🙋🏻♂️ 개발자랑 회의하기 어려워하는 기획자에게 특히 추천🙋🏻♂️ (PLAUD NotePin)

2025. 5. 14.

Gemini 2.0 Flash + Cline & Aider : This is THE BEST FREE AI Coding Setup RIGHT NOW!

2024. 12. 12.

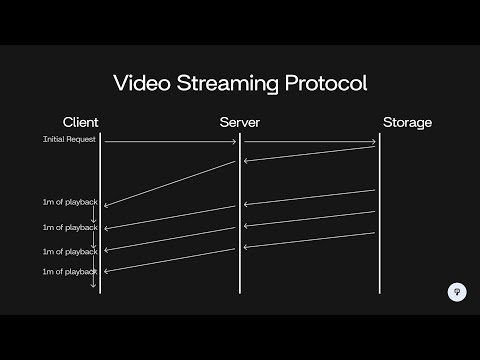

Design a Video Streaming Protocol (HLS, DASH) | System Design

2024. 2. 17.

AI Powered Racecar Breaks Speed Record

2025. 3. 6.

이미지 용량 줄이는 VS Code 플러그인 #webp

2025. 5. 7.