당

당근

July 3, 20251회

연간 LLM 호출 비용 25% 절감, 인턴이 도전한 시맨틱 캐싱 도입 기록

간단 소개

당근 채팅팀 인턴의 시맨틱 캐싱 도입으로 LLM 호출 비용을 25% 절감한 사례와 향후 확장 계획을 소개합니다.

AI Summary

- LLM 호출 비용 절감 배경

- 당근 채팅팀은 AI 메시지 추천 기능을 통해 사용자 편의성을 높였으나, LLM 호출 비용이 과도하게 높다는 문제에 직면.

- 시맨틱 캐싱 기술을 도입하여 비용 효율성을 개선하고자 함.

- 시맨틱 캐싱의 도입 및 효과

- 시맨틱 캐싱은 문장 간 의미 유사도를 활용하여 캐시 적중률을 높이는 기술.

- 코사인 유사도를 활용, 유사도가 높은 문장을 캐시 HIT으로 처리하여 LLM 호출 비용을 절감.

- 오프라인/온라인 테스트 결과, 시맨틱 캐싱은 약 25%의 캐시 HIT 비율을 기록, 연간 2.1억 원의 비용 절감 효과를 보임.

- 향후 계획

- 머신러닝 분석 및 벡터 DB 구성 자동화를 통해 시맨틱 캐싱 기능의 확장성을 높일 계획.

- 중고거래 외 다양한 도메인에 시맨틱 캐싱을 적용하여 당근 서비스 전반의 채팅 경험을 개선할 예정.

Next Feeds

Amazon Q Developer 를 이용한 엑심베이의 JDK 자동화 업그레이드 사례

엑심베이는 Amazon Q Developer를 활용하여 JDK 업그레이드를 자동화하고 개발 생산성을 향상시켰습니다.

Amazon Q DeveloperJDK 업그레이드자동화개발 생산성엑심베이

2025. 7. 3.

AWS

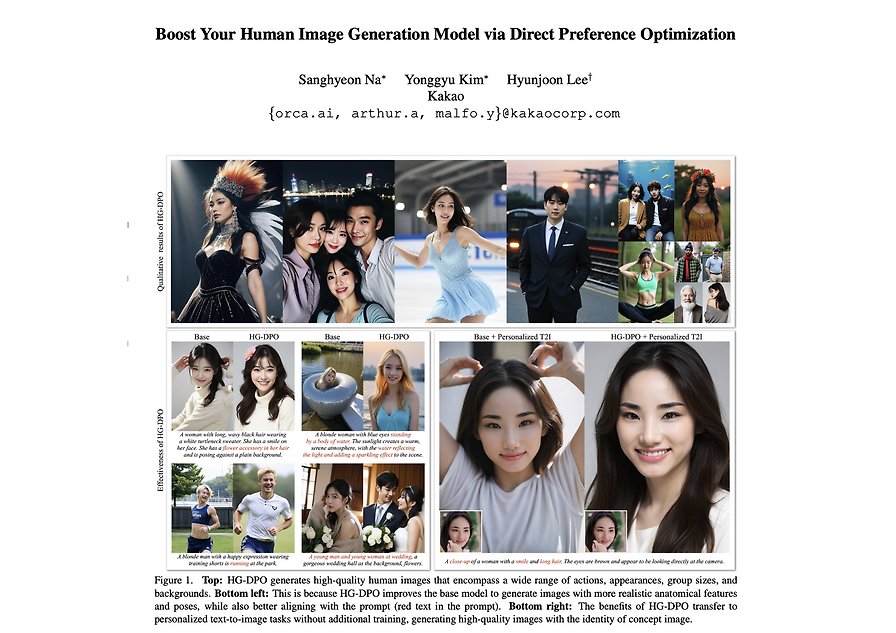

CVPR 2025 참관기: 고품질 인물 생성을 위한 HG-DPO 연구 소개

CVPR 2025에서 카카오 AI팀이 발표한 HG-DPO 연구는 Diffusion model 기반 인물 이미지 생성 모델의 품질을 향상시키는 새로운 DPO 학습 방식이다.

CVPR 2025HG-DPODiffusion model이미지 생성카카오 AI

2025. 7. 3.

카카오

AI가 지켜보는 데이터 파이프라인: 노이즈 제거부터 장애 대응까지

AI를 활용하여 데이터 파이프라인 운영 효율성을 높이고 장애 대응을 자동화하는 방법을 소개합니다.

AI데이터 파이프라인운영 자동화장애 처리Noise 제거

2025. 7. 2.

Naver d2

Nexthink가 Amazon Managed Service for Apache Flink를 사용하여 실시간 알림을 구축한 방법

Nexthink는 Amazon Managed Service for Apache Flink를 사용하여 실시간 알림 시스템을 구축, 확장성 및 유연성을 향상시켰습니다.

NexthinkApache FlinkAmazon MSK실시간 알림VDI

2025. 7. 2.

AWS

여기어때의 성장 지원 제도

여기어때는 온라인 교육, 외부 교육, 도서 구매, 사외 강사 특강 등 다양한 성장 지원 제도를 통해 구성원의 역량 개발을 적극 지원한다.

성장교육지원역량여기어때

2025. 7. 2.

여기어때

양자 컴퓨팅이란 무엇인가? – Part 3

양자 컴퓨팅의 핵심 개념(큐비트, 중첩, 얽힘)과 고전 컴퓨터와의 차이점을 설명하고, 양자 연산의 기본 원리를 소개합니다.

양자 컴퓨팅큐비트양자 중첩양자 얽힘양자 측정

2025. 7. 2.

AWS