카

카카오

January 14, 20261회

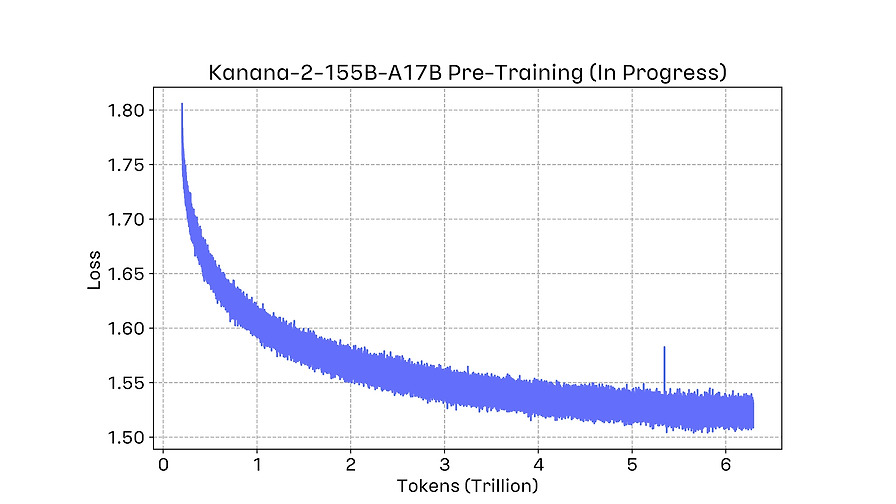

Kanana-2 개발기 (1): Pre-training에서의 의사결정들을 중심으로

간단 소개

카카오의 차세대 언어모델 Kanana-2 개발기가 MoE 아키텍처, Muon Optimizer, FP8 인프라 최적화 등 Pre-training 의사결정을 중심으로 설명됩니다.

AI Summary

Kanana-2 모델 공개 및 특징

- 카카오가 자체 개발한 차세대 언어모델 Kanana-2 4종(Base, Mid-training, Instruct, Thinking) 공개.

- 전문가 혼합(MoE) 아키텍처 채택으로 32B 파라미터 지능을 3B 활성화하여 연산 효율 극대화.

- 고효율 저비용 모델로, FP8 training 및 MuonClip 등 기술 적용. Pre-training 핵심 의사결정

- Muon Optimizer 채택 및 Polar Express 적용으로 안정적인 훈련 달성.

- MuonClip을 통해 Attention Logit 발산 문제 해결 및 훈련 안정성 확보.

- 2-step Hyperparameter Transfer (데이터 Scaling Law + 모델 MuP)로 대규모 모델의 LR 최적화. 인프라 최적화

- FP8 Training을 위한 Fine-grained Scaling 및 Non-GEMM 커널 직접 개발.

- Multi-GPU GC 동기화, Distributed Asynchronous Checkpointing 도입으로 훈련 효율성 증대.

- Prefect를 활용한 체크포인팅 워크플로우 자동화.

Next Feeds

FE News 26년 1월 소식을 전해드립니다!

네이버 FE News 26년 1월호는 RSC 시각화 도구, 클라이언트 사이드 AI 트렌드, 디자인시스템과 AI 활용 마크업 자동화 소식을 다룹니다.

React Server Components클라이언트 사이드 AIWeb AI Summit디자인시스템마크업 자동화

2026. 1. 14.

Naver d2

엔터프라이즈 LLM 서비스 구축기 1: 컨텍스트 엔지니어링

LY Corporation의 Flava AI 어시스턴트 구축 과정에서 LLM 성능 향상을 위한 컨텍스트 엔지니어링 전략과 '점진적 공개' 방식을 상세히 설명합니다.

컨텍스트 엔지니어링LLMFlava AI 어시스턴트RAG점진적 공개

2026. 1. 14.

LY Corp

꺼진 광고 매출 다시 보자

알라미는 광고를 '제품'처럼 운영하여 인앱 광고 매출 최고치를 경신했으며, 이 노하우를 담은 수익화 솔루션 DARO를 통해 다른 앱들의 지속적인 광고 매출 성장을 돕는다.

광고 매출알라미DARO수익화 전략그로스

2026. 1. 14.

딜라이트룸

TwelveLabs Marengo를 활용한 Amazon Bedrock에서의 영상 이해 기술 구현

Amazon Bedrock과 TwelveLabs Marengo를 활용한 멀티모달 비디오 이해 및 교차 모달 검색 솔루션 구현.

TwelveLabs MarengoAmazon Bedrock비디오 이해멀티모달 AI벡터 데이터베이스

2026. 1. 14.

AWS

Claude Code 컨텍스트 최적화 가이드

Claude Code 사용 시 LLM의 컨텍스트 부패를 방지하고 코드 품질을 높이기 위한 4가지 최적화 방법을 제시한다.

Claude Code컨텍스트 최적화LLMCLAUDE.md프롬프트

2026. 1. 14.

인포그랩

Strands Agent SOPs 소개 – AI 에이전트를 위한 자연어 워크플로우

AI 에이전트의 일관성 및 신뢰성 문제를 해결하기 위해 자연어 기반의 표준화된 마크다운 워크플로우인 Agent SOPs를 소개하고 활용법을 설명합니다.

Agent SOPsAI 에이전트자연어 워크플로우프롬프트 엔지니어링표준화된 마크다운

2026. 1. 13.

AWS