- Qwen 3는 Alibaba의 최신 AI 모델 시리즈로, 6개의 밀집 모델(6억~320억 매개변수)과 2개의 MoE(Mixture-of-Experts) 모델을 포함합니다. 🚀

- 주력 MoE 모델(2350억 매개변수)과 소형 MoE 모델(300억 매개변수)이 있으며, 특히 소형 MoE는 코딩 및 수학 벤치마크에서 GPT-4o를 능가하는 뛰어난 성능을 보입니다. 🏆

- 모든 Qwen 3 모델은 Apache 2 라이선스를 따르는 오픈 소스입니다. 🔓

- 코딩 작업에 특화되어 Gemini 2.5 Pro 등 경쟁 모델을 대부분 능가합니다. 💻

- MoE 모델은 활성 매개변수만 사용하여 더 나은 성능과 낮은 추론 비용을 제공합니다. 💰

- 32,000에서 최대 128,000 토큰의 긴 컨텍스트 길이를 지원합니다(80억 매개변수 이상 모델). 📚

- Hugging Face, ModelScope, Kaggle 및 Olama 등 로컬 환경에서 쉽게 접근하고 실행할 수 있습니다. 🌐

- Alibaba의 첫 하이브리드 사고 모델로, 복잡한 문제에는 단계별 사고를, 간단한 질문에는 즉각적인 응답을 제공합니다. 🤔

- 최대 119개 언어 및 방언을 지원하여 다국어 활용도가 높습니다. 🗣️

- 도구 호출(tool calling) 및 다단계 복합 문제 해결(MCP)과 같은 에이전트 기능에 최적화되어 있습니다. 🛠️

- Qwen 2.5 대비 두 배 증가한 약 36조 개의 토큰으로 훈련되었으며, 고품질 웹/PDF 데이터와 합성 데이터를 활용했습니다. 📈

- 현재는 텍스트 입력 및 텍스트 출력만 지원하는 텍스트 전용 모델입니다. ✍️

- Llama 4 Maverick보다 작고 빠르며 저렴하면서도, 일반, 수학, 다국어, 코딩 등 대부분의 벤치마크에서 우수한 성능을 보입니다. ⚔️

- AI 기술 발전의 빠른 속도를 보여주며, 불과 몇 주 만에 새로운 모델이 기존 벤치마크를 뛰어넘습니다. ⚡

- 웹 개발 작업 테스트에서 Claude 3.7 및 Gemini 2.5 Pro와 유사하거나 더 나은 응답을 제공하여 초기 사용자 경험이 매우 긍정적입니다. 👍

- chat.qwen.ai를 통해 MoE 모델 및 320억 밀집 모델을 간편하게 체험할 수 있습니다. 💬

Recommanded Videos

챗GPT 무료 특강 #2 (프롬프트 엔지니어링)

2025. 1. 30.

8 HTML Tags You’ve Probably Never Used

2025. 5. 29.

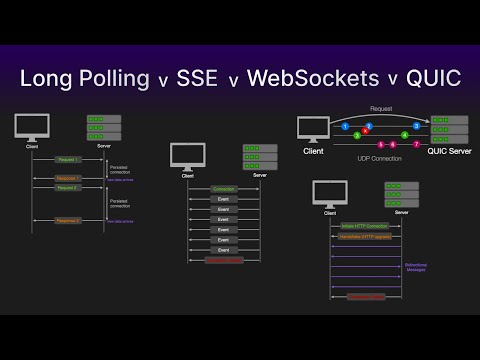

Long Polling vs SSE vs WebSockets vs QUIC | Simply Explained

2024. 10. 4.

Hacks you need when building a React Native Game

2024. 11. 28.

한글 넣은 이미지 생성 AI 대결 결과는? 챗GPT vs 나노 바나나 vs 그록4

2025. 11. 18.

사람들이 쓰는 앱을 만드려면, "문제 발견"을 어떻게 할까?

2025. 11. 29.