- LLM 평가는 비결정론적 시스템인 LLM을 활용하는 대규모 AI 앱 개발에 필수적입니다. 🚀

- 평가는 AI의 출력을 미리 정의된 사실이나 규칙(주로 인간 기준)과 비교하여 작업 성공 여부를 판단하는 과정입니다. ⚖️

- 효과적인 평가를 위해서는 입력, 메타데이터, 인간이 생성한 예상 출력(점수 및 해설)을 포함하는 고품질 데이터셋 구축이 중요합니다. 📊

- 평가는 점수 편차를 측정하는 정량적 방식과 AI 및 인간 해설 간의 의미론적 유사성을 평가하는 정성적 방식으로 나뉩니다. 🎯

- 일반적인 평가 워크플로우는 고품질 데이터셋으로 실험을 실행하고, AI 출력을 예상 결과와 비교하는 '스코어러'를 사용합니다. 🧪

- 평가 프레임워크 구축의 가장 큰 과제는 신뢰할 수 있는 고품질 데이터셋을 확보하는 것입니다. 🏗️

- 시장에는 Langfuse(오픈소스, 복잡한 UI), Evalite(로컬 실행, 학습용), Brain Trust(직관적 UI, 비공개 소스)와 같은 다양한 LLM 평가 도구가 있습니다. 🛠️

- Langchain 사용자를 위한 Langsmith와 또 다른 오픈소스 도구인 a.ai도 고려해볼 만합니다. ✨

Recommanded Videos

Spring AI Superpowers 🤖 | Integrate Gemini AI in Minutes 🚀

2025. 12. 6.

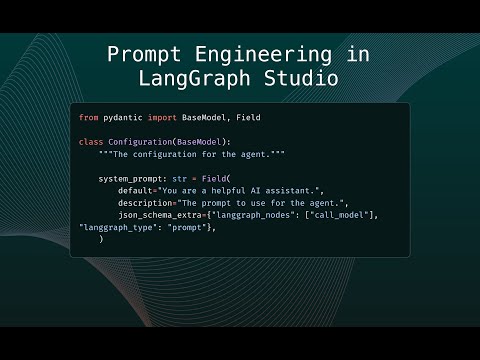

Prompt Engineering in LangGraph Studio

2025. 3. 19.

2024 10 15 20 14 20

2024. 10. 27.

Should Developers Use AI Tools?

2025. 12. 9.

Vue.js Nation 2025: Thorsten Seyschab - Your Own Vite Plugin? That's as easy as 1 2 3(D)

2025. 2. 6.

클로드 코드 업데이트 Background Bash

2025. 8. 20.