- Lablup은 "연구실 업그레이드"라는 목표로 설립되어, Backend.AI 솔루션을 통해 대규모 AI 생성 및 서비스를 가능하게 함. 🚀

- 2018년 초 모델과 2021년 말 모델 크기는 약 2만 배 차이가 나며, 이는 AI 모델의 급격한 성장세를 보여줌. 📈

- 초기에는 RNN과 LSTM을 활용한 sequence-to-sequence 모델이 주를 이루었으며, 특히 번역기 개발에서 신경망 기반 방식이 빠르게 기존 통계 기반 방식을 대체함. 🌐

- 언어 모델 개발 과정에서 언어와 무관하게 유사한 구조가 발견되었고, 이는 Universal Sentence Encoder와 같은 기술로 이어져 Transfer Learning과 Fine-tuning 발전에 기여함. 🧠

- 2017년 AlphaGo 이후 AI에 대한 관심이 폭발적으로 증가했으며, Google Neural Machine Translation 모델은 AI의 실질적인 유용성을 보여주는 대표적인 사례가 됨. 🤖

- 2019년부터 모델 크기가 급격히 커지면서 100억 개 이상의 파라미터를 쉽게 넘어서게 되었고, 언어 모델이 '언어 효과'를 가지는지에 대한 논의가 활발하게 진행됨. 🤔

- ChatGPT가 수학 문제를 푸는 것을 보고 사람들이 실망했지만, 이는 모델이 수학을 학습하지 않았음에도 불구하고 자체적으로 논리 구조를 생성하여 계산을 수행한다는 점에서 놀라운 결과임. 🧮

- 2019년에는 Transformer가 그래프 신경망과 수학적으로 동일해질 수 있다는 사실이 발견되었으며, 이는 Transformer가 객체 간 관계 학습에 특화된 구조임을 시사함. 🔗

- GPT-3는 1000억 개 이상의 파라미터를 가지며, 콘텐츠 생성 능력과 다중 모드 가능성을 보여주었고, 이는 AI 모델의 활용 범위를 확장하는 데 기여함. 🎨

- ChatGPT는 1억 명 이상의 활성 사용자를 처리하기 위해 모델 크기를 줄였을 가능성이 있으며, 8비트 양자화 또는 더 작은 모델을 내부적으로 사용할 수 있다는 추측이 있음. 💡

- PaLM 2는 모델 크기를 540B에서 340B로 줄였으며, Transformer 기반 모델에서 전체 레이어를 양자화하는 것은 위험하기 때문에 일부 레이어만 양자화하는 방식을 사용함. 📉

Recommanded Videos

듣기싫은 소리 잘하는 노프팀장

2024. 8. 10.

AI로 생기는 신종 해킹수법 #shorts

2025. 7. 10.

How to Customize Colors in Tailwind CSS

2024. 12. 23.

My 7 startups made $68,140 in August (as a Solopreneur)

2024. 9. 6.

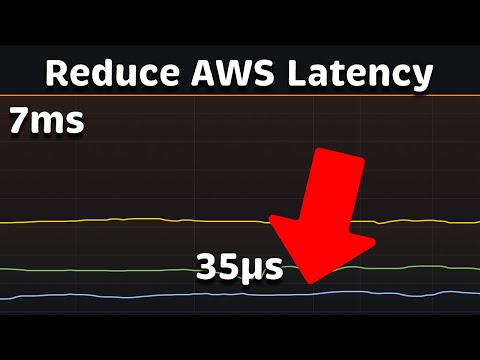

Reduce AWS Latency by 200x: Drop from 7ms to 35μs

2025. 10. 12.

![[수능 특집] 시험 해킹 사건사고, 수능 끝나고 알찬 방학 만들기](https://i1.ytimg.com/vi/tBD6-Kyf2O0/hqdefault.jpg)

[수능 특집] 시험 해킹 사건사고, 수능 끝나고 알찬 방학 만들기

2024. 11. 19.