- AI 에이전트는 추론, 도구 사용, 멀티모달 기능이 발전했음에도 불구하고 '컨텍스트 윈도우' (메모리 용량) 문제에 직면해 있으며, 이는 지난 1년간 거의 개선되지 않았습니다. 🧠

- 컨텍스트 길이는 토큰으로 측정되는 원시 용량, 컨텍스트 품질, 메모리 및 컴퓨팅 비용, 알고리즘 효율성이라는 네 가지 핵심 요소가 상호작용하며 현재 한계에 부딪히고 있습니다. 📊

- 현재 최전선 모델의 컨텍스트 윈도우는 Google Gemini 1.5 Pro와 OpenAI GPT-4.1이 달성한 100만 토큰에 머물러 있으며, 이 장벽은 거의 2년 동안 깨지지 않고 있습니다. 🚧

- Meta의 Llama 4가 1,000만 토큰을 주장하지만, 이는 최전선 모델로 간주되지 않으며, 훈련 컨텍스트가 25만 6천 토큰에 불과하여 실제 사용 시 품질 저하가 발생할 수 있습니다. 📉

- '중간 손실 문제'는 모델이 컨텍스트 윈도우의 중간에 있는 정보를 처리할 때 성능이 크게 저하되는 현상으로, 긴 컨텍스트를 위해 설계된 모델에서도 나타납니다. 🔍

- 긴 컨텍스트는 복잡한 작업을 가능하게 하지만, 모델이 전체 컨텍스트에 균일하게 주의를 기울이기 어렵고, 비용이 증가하며, 노이즈로 인해 성능이 저하될 수 있는 위험이 있습니다. ⚠️

- 미래 해결책은 크게 세 가지로 나뉩니다: GPU 메모리 비용을 낮추는 대규모 인프라 투자, 하드웨어 제약을 우회하는 알고리즘 혁신, 그리고 컨텍스트를 지능적으로 관리하는 전략입니다. 🚀

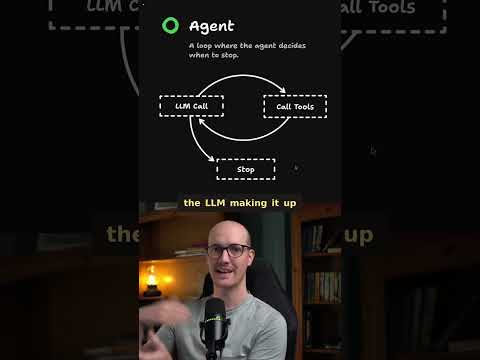

- 핵심 원칙은 컨텍스트 길이가 아닌 '컨텍스트 품질'이 더 중요하다는 것, 메모리 경제성이 채택을 결정한다는 것, 그리고 에이전트 아키텍처가 컨텍스트 제한을 고려해야 한다는 것입니다. ✨

- 엔지니어는 지능적인 컨텍스트 관리(요약 및 압축)와 효율적인 워크플로우 설계에 집중하고, 기업 AI 전략가는 멀티모달 컨텍스트의 높은 비용을 이해하고 사용 패턴을 감사해야 합니다. 🛠️

Recommanded Videos

프로답게 피드백하는 3가지 방법

2025. 7. 9.

Alicja Ogonowska: No Backend? No Problem! Flutter apps with Firebase Extensions 🧩

2024. 9. 25.

Don’t Build Another API Without This…

2025. 11. 25.

![[풀버전] ′24 깃헙 유니버스, 웨이모, 샌프란시스코 오피스 투어](https://i4.ytimg.com/vi/7KJxz1O2DB4/hqdefault.jpg)

[풀버전] ′24 깃헙 유니버스, 웨이모, 샌프란시스코 오피스 투어

2024. 12. 13.

THIS Is Why You Need To Use Tweens

2025. 3. 27.

What even are Agents and Workflows?

2025. 9. 24.