현

현대자동차

October 24, 20241회

[#2 LLM Tutorial With RAG] 내 컴퓨터에 Chat GPT를 설치하자 With Ollama

간단 소개

Ollama를 사용하여 개인 PC에 Chat GPT를 설치하고, Hugging Face의 LLM 모델과 Modelfile을 통해 LLM을 제어하는 방법을 설명합니다.

AI Summary

- Ollama 소개 및 설치

- Ollama는 LLM을 쉽게 사용할 수 있도록 포장하는 플랫폼으로, 다양한 인터페이스(Web, Code, CLI)를 지원한다.

- 윈도우 명령 프롬프트에서

ollama --version명령어를 통해 설치 확인이 가능하다.

- Hugging Face를 활용한 LLM 모델 사용

- Hugging Face는 인공지능 모델 가중치가 공유되는 커뮤니티로, EEVE와 같은 한국어 LLM을 사용할 수 있다.

- gguf 파일 형태로 저장된 모델을 다운로드하여 사용하며, 라이선스 정책 확인이 필수적이다.

- Modelfile을 통한 LLM 제어 및 실행

- Modelfile은 LLM의 작동 방식(출력 글자 수, 답변 형태 등)을 정의하는 설정 파일이다.

- Modelfile과 gguf 파일을 같은 폴더에 넣고

ollama create my_llm -f ./Modelfile명령어로 설치 후,ollama run my_llm으로 실행한다. - Code 레벨에서 LLM을 구현하고 RAG 기술을 도입하여 Hallucination 문제를 해결할 수 있다.

Next Feeds

과격하게 레거시를 쇄신하는 세 가지 방법과 그 사례

데마에칸의 레거시 쇄신 사례를 통해 인프라 단절, 코드 재작성, 사양 경량화의 세 가지 과격한 레거시 해소 방법을 소개하고, 지속 가능한 서비스 구축 방향을 제시합니다.

레거시쇄신인프라 단절코드 재작성사양 경량화

2024. 10. 23.

LY Corp

엑셀 업로드 중 발생한 Zip Bomb 에러 파헤치기! 🥊

엑셀 파일 업로드 중 발생한 Zip Bomb 에러의 원인을 분석하고 해결하는 과정을 공유하며, 로그 분석의 중요성을 강조합니다.

Zip Bomb엑셀 파일압축 해제Apache POI로그 분석

2024. 10. 23.

컬리

재고 서비스의 진화와 혁신: 지속적인 개선을 통한 안정성과 확장성 강화

무신사 재고 서비스의 혁신 과정과 주요 기술 도입, 성과, 그리고 향후 개선 계획을 담고 있습니다.

재고관리ERPRedisKafka마이크로서비스

2024. 10. 23.

무신사

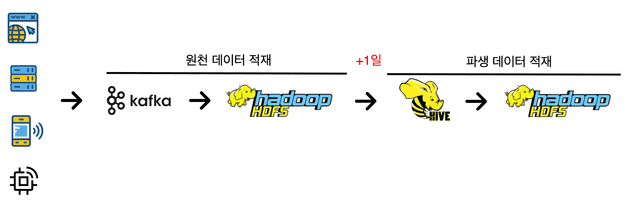

Spark Streaming을 활용한 파생 데이터 생성 시간 감축 사례

Spark Streaming을 활용하여 파생 데이터 생성 시간을 단축하고 실시간 데이터 처리 시스템을 구축한 사례를 소개합니다.

Spark StreamingKafka데이터 파이프라인실시간 데이터 처리모니터링

2024. 10. 23.

skplanet

[#1 LLM Tutorial With RAG] 나만의 Chat GPT를 만들어봅시다!

RAG 기술을 활용하여 LLM의 한계를 극복하고, 나만의 Chat GPT를 만드는 튜토리얼을 소개합니다.

LLMRAGChat GPTLangChainOllama

2024. 10. 22.

현대자동차

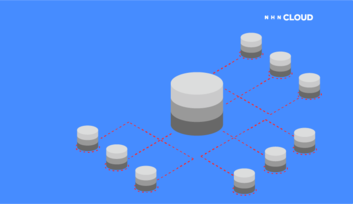

멀티 테넌트 데이터를 격리하고 더 안전하게 만드는 방법

멀티 테넌트 환경에서 데이터 격리 수준을 높이고 보안을 강화하는 방법과 고려 사항을 제시합니다.

멀티 테넌트데이터 격리테넌트 ID암호화보안

2024. 10. 21.

NHN