- Align Evals는 LLM 애플리케이션 평가를 간소화하여, LLM을 심판으로 사용하는 평가자 생성 과정을 데이터 라벨링 방식으로 개선합니다. 🚀

- Langsmith는 LLM 애플리케이션 관찰 및 평가 플랫폼으로, Langchain과 함께 또는 독립적으로 사용 가능하며, 에이전트 평가를 위한 효율적인 흐름을 제공합니다. 🔬

- Align Evals의 핵심은 대표적인 샘플 실행을 수집하고, 전문가가 라벨링한 데이터를 기반으로 LLM 심판 프롬프트를 반복적으로 개선하여 사람의 판단과 일치도를 높이는 것입니다. 🧑🏫

- 레시피 생성 예시에서 불필요한 형용사 제거 기준을 평가하기 위해, 데이터셋에 평가자를 추가하고 실험을 라벨링하여 LLM 심판 프롬프트를 생성하고 조정합니다. 🍳

- 평가자 플레이그라운드에서 프롬프트를 작성하고 실행 결과와 사람의 라벨링을 비교하여 정렬도를 측정하며, 필요에 따라 프롬프트를 수정하여 정렬도를 개선합니다. ✍️

- 모델 변경, 추론 포함 등의 조정을 통해 평가자의 정확도를 높이고, 새로운 실험을 실행하여 개선된 평가자를 통해 프롬프트의 성능을 평가합니다. 🎯

- Langsmith를 통해 프롬프트와 평가자를 반복적으로 개선하고, Align Evals의 편리한 UX를 통해 데이터 라벨링 및 평가자 정렬을 효율적으로 수행할 수 있습니다. ✨

- Eugene Yan의 Align Eval에서 영감을 받아 개발되었으며, 현재 일반 사용이 가능합니다. 🙏

Recommanded Videos

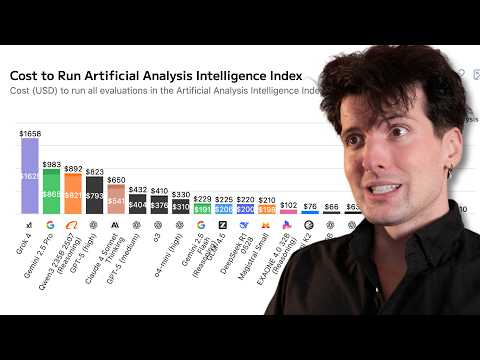

I was wrong about AI costs (they keep going up)

2025. 8. 18.

A Chat with the Founder of Blender, Ton Roosendaal | Bad Decisions Podcast #69

2025. 9. 5.

I added a connect to Youtube feature (upload videos to youtube from your apps)

2024. 9. 30.

OOP에서 진짜 중요한 건 '캡슐화'도 '상속'도 아닙니다

2025. 8. 11.

미국발 관세전쟁 개발자 직업이 비교적 안전한 이유

2025. 4. 10.

리눅스 나무위키를 읽어보았습니다.

2025. 5. 15.