Loading...

Recommanded Videos

플러터 3.29 업데이트 호다닥 알아보기

2025. 2. 27.

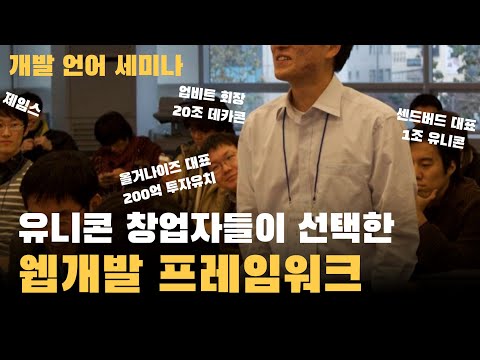

왜 레일즈 개발자들은 창업을 하는가? 그들은 왜 회사가 커져도 개발을 좋아할까?

2025. 3. 6.

![[KO] 비디오 생성모델로 Reasoning을 해보자?](https://i1.ytimg.com/vi/DxMfIOPAzxE/hqdefault.jpg)

[KO] 비디오 생성모델로 Reasoning을 해보자?

2025. 12. 17.

![useEffect 실습편 [ 리액트 (React + Typescript) ]](https://i1.ytimg.com/vi/4A2YHiDcDiE/hqdefault.jpg)

useEffect 실습편 [ 리액트 (React + Typescript) ]

2024. 5. 22.

Simplest way to build Portfolio (Next.js, Shadcn, TypeScript, Tailwind)

2024. 8. 23.

AI뉴스 - 충격적인 음성 AI Dia, 딥시크 R2 유출, 4o 이미지 API 출시, 1100만 토큰 무료, 퍼플렉시티 Assistant, HyperCLOVA X SEE 등

2025. 4. 28.