-

🦙 Llama 3.2를 로컬로 실행하는 방법을 배울 수 있습니다.

-

📲 Llama CPP를 사용하여 컴퓨터에 Llama 서버 및 클라이언트를 구축할 수 있습니다.

-

🖥️ Mac 또는 Linux에서 이 방법을 사용할 수 있으며, Windows 사용자는 다른 방법을 사용해야 합니다.

-

🐍 Llama CPP는 파이썬을 사용하여 쉽게 설치하고 실행할 수 있습니다.

-

💬 Local하게 실행되므로 다른 앱과 연결하고, 직접 텍스트 기반 챗을 즐길 수 있습니다.

-

🌐 OpenAI와 호환 가능한 API를 제공하여 다양한 앱과 통합 가능합니다.

-

💪 2048개의 토큰 맥락 창을 사용하여 긴 대화 내역을 처리할 수 있습니다.

-

✨ 다양한 Llama 모델(3.1, 100만 파라미터, 32 파라미터)을 지원합니다.

Recommanded Videos

YEPS 2025 (Seattle Tech Week) aude.ai - The System of Record for Engineering Performance

2025. 9. 24.

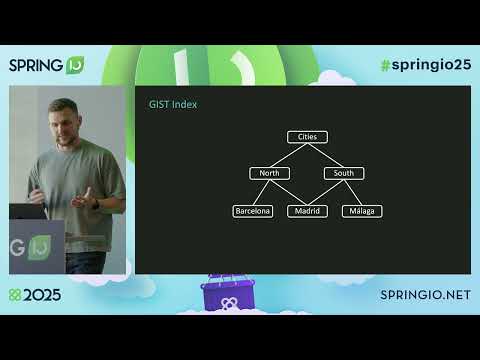

You don't need Elasticsearch! Fuzzy Search with PostgreSQL and Spring Data by Thomas Gräfenstein

2025. 9. 2.

#FlutterFlightPlans: Talabat, Material & Cupertino, Jaspr, build_runner, GenUI, ADK, and Live Q&A!

2025. 12. 17.

데이터 사이언스 분야의 일을 하기 위해 가져야할 소양들에 대해 #datascience #미국취업 #개발자취업 #shorts

2025. 5. 28.

Build an AI Agent Social Media Team | No-Code Guide

2024. 8. 14.

배달 로봇을 위한 맵 서비스: 강남 한복판에서 달리는 법 #우아콘2025 #우아한형제들

2025. 12. 8.